Метод обработки статистических данных, заключающийся в изучении коэффициентов (корреляции) между переменными, называется корреляционным анализом.

Для оценивания силы линейной зависимости объясняемой переменной (у) от потенциальных объясняющих переменных (лсь х2, . хт) по приведенной ниже формуле рассчитываются коэффициенты корреляции, которые записываются в виде вектора корреляции R0:

Коэффициенты корреляции между потенциальными объясняющими переменными хи х2, . хт рассчитываются по приведенной ниже формуле и записываются в виде матрицы корреляции R:

Матрица R симметрична относительно единичной диагонали, т е. Гу = />

Тесноту влияния всех объясняющих переменных на результат позволяет определять коэффициент (индекс) множественной корреляции:

Величина индекса множественной корреляции лежит в пределах от 0 до 1 и должна быть больше или равна максимальному парному индексу корреляции: RyXx. Xn ^гух.(тах).

Чем ближе значение индекса множественной корреляции к 1, тем теснее связь результативного признака и набора исследуемых переменных.

Сравнивая индексы множественной и парной корреляции, можно сделать вывод о целесообразности (величина индекса множественной корреляции существенно отличается от индекса парной корреляции) включения в уравнение регрессии того или иного фактора.

При линейной зависимости совокупный коэффициент множественной корреляции определяется через матрицу парных коэффициентов корреляции:

где Аг= — определитель матрицы парных коэф-

фициентовкорреляции; Агп = » —определитель

матрицы межфакгорной корреляции.

В [9, с. 33] коэффициент множественной корреляции рассчитывается по формуле

где AR — определитель матрицы R коэффициентов корреляции попарно объединенных объясняющих переменных хь х2, . х„; AW— определитель матрицы W, представленной в следующем виде:

где R0 — вектор коэффициентов корреляции между переменной у и объясняющими переменными хь х2. хп.

Частные коэффициенты корреляции характеризуют тесноту линейной зависимости между результатом и соответствующим фактором при устранении влияния других факторов. Если вычисляется, например, г уХхХ2 (частный коэффициент корреляции между у и х<

при фиксированном влиянии х2), то это означает, что определяется количественная мера линейной зависимости у от хь которая будет иметь место, если устранить влияние на эти признаки фактора х2.

Частные коэффициенты корреляции, измеряющие влияние на у фактора х,- при неизменном уровне других факторов, можно определить так:

или по рекуррентной формуле:

Для двухфакторного уравнения частные коэффициенты корреляции рассчитывают по следующим формулам:

Частные коэффициенты корреляции изменяются в пределах от — 1 до +1.

Сравнение значений парного и частного коэффициентов корреляции показывает направление воздействия фиксируемого фактора. Если частный коэффициент корреляции гуХ[^ получится меньше, чем соответствующий парный коэффициент гуХ<, значит, взаимосвязь признаков у и Х в некоторой степени обусловлена воздействием на них фиксируемой переменной х2. И наоборот, большее значение частного коэффициента по сравнению с парным свидетельствует о том, что фиксируемая переменная х2 ослабляет своим воздействием связь у и х.

Порядок частного коэффициента корреляции определяется количеством факторов, влияние которых исключается. Например, г уХх2

коэффициент частной корреляции первого порядка.

Зная частные коэффициенты корреляции (последовательно первого, второго и более высокого порядка), можно определить совокупный коэффициент множественной корреляции:

Качество построенной модели в целом оценивает коэффициент (индекс) множественной детерминации, который рассчитывается как квадрат индекса множественной корреляции (RyxY. Xn ) 2 ? Коэффициент множественной детерминации фиксирует долю объясненной вариации результативного признака за счет рассматриваемых в регрессии факторов. Влияние других, не учтенных в модели факторов, оценивается как 1 — R 2 .

Если число параметров при х,- близко к объему наблюдений, то коэффициент множественной корреляции приближается к единице даже при слабой связи факторов с результатом. Чтобы не допустить возможного преувеличения тесноты связи, используется скорректированный индекс множественной корреляции, который содержит поправку на число степеней свободы:

где к — число объясняющих переменных; п — число элементов в выборке.

Чем больше к, тем сильнее различия R 2 и R 2 .

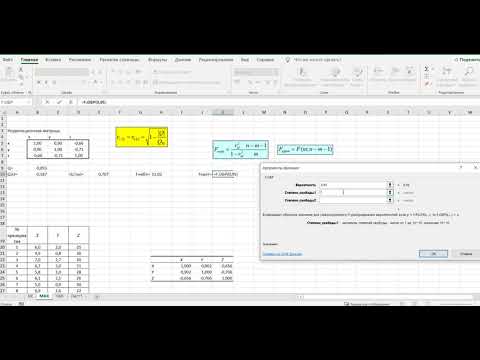

Видео:Коэффициент корреляции Пирсона в ExcelСкачать

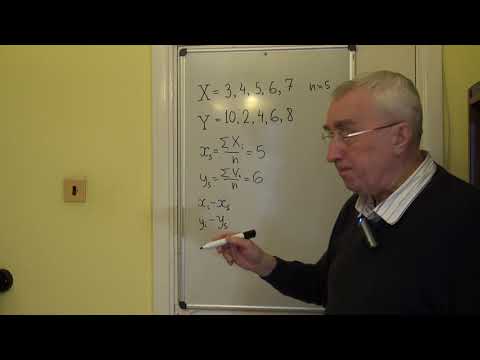

Корреляция, ковариация и девиация (часть 3)

В первой части показано, как на основе матрицы расстояний между элементами получить матрицу Грина. Ее спектр образует собственную систему координат множества, центром которой является центроид набора. Во второй рассмотрены спектры простых геометрических наборов.

В данной статье покажем, что матрица Грина и матрица корреляции — суть одно и то же.

Видео:Расчет коэффициента корреляции в ExcelСкачать

7. Векторизация и нормирование одномерных координат

Пусть значения некой характеристики элементов заданы рядом чисел . Для того, чтобы данный набор можно было сравнивать с другими характеристиками, необходимо его векторизовать и обезразмерить (нормировать).

Для векторизации находим центр (среднее) значений

и строим новый набор как разность между исходными числами и их центроидом (средним):

Получили вектор. Основной признак векторов состоит в том, что сумма их координат равна нулю. Далее нормируем вектор, — приведем сумму квадратов его координат к 1. Для выполнения данной операции нам нужно вычислить эту сумму (точнее среднее):

Теперь можно построить ССК исходного набора как совокупность собственного числа S и нормированных координат вектора:

Квадраты расстояний между точками исходного набора определяются как разности квадратов компонент собственного вектора, умноженные на собственное число. Обратим внимание на то, что собственное число S оказалось равно дисперсии исходного набора (7.3).

Итак, для любого набора чисел можно определить собственную систему координат, то есть выделить значение собственного числа (она же дисперсия) и рассчитать координаты собственного вектора путем векторизации и нормирования исходного набора чисел. Круто.

Упражнение для тех, кто любит «щупать руками». Построить ССК для набора .

Видео:Коэффициент корреляции Пирсона, 2 способа вычисленияСкачать

8. Векторизация и ортонормирование многомерных координат

Что, если вместо набора чисел нам задан набор векторов — пар, троек и прочих размерностей чисел. То есть точка (узел) задается не одной координатой, а несколькими. Как в этом случае построить ССК? Стандартный путь следующий.

Введем обозначение характеристик (компонент) набора. Нам заданы точки (элементы) и каждой точке соответствует числовое значение характеристики

. Обращаем внимание, что второй индекс

— это номер характеристики (столбцы матрицы), а первый индекс

— номер точки (элемента) набора (строки матрицы).

Далее векторизуем характеристики. То есть для каждой находим центроид (среднее значение) и вычитаем его из значения характеристики:

Получили матрицу координат векторов (МКВ) .

Следующим шагом как будто бы надо вычислить дисперсию для каждой характеристики и их нормировать. Но хотя таким образом мы действительно получим нормированные векторы, нам-то нужно, чтобы эти векторы были независимыми, то есть ортонормированными. Операция нормирования не поворачивает вектора (а лишь меняет их длину), а нам нужно развернуть векторы перпендикулярно друг другу. Как это сделать?

Правильный (но пока бесполезный) ответ — рассчитать собственные вектора и числа (спектр). Бесполезный потому, что мы не построили матрицу, для которой можно считать спектр. Наша матрица координат векторов (МКВ) не является квадратной — для нее собственные числа не рассчитаешь. Соответственно, надо на основе МКВ построить некую квадратную матрицу. Это можно сделать умножением МКВ на саму себя (возвести в квадрат).

Но тут — внимание! Неквадратную матрицу можно возвести в квадрат двумя способами — умножением исходной на транспонированную. И наоборот — умножением транспонированной на исходную. Размерность и смысл двух полученных матриц — разный.

Умножая МКВ на транспонированную, мы получаем матрицу корреляции:

Из данного определения (есть и другие) следует, что элементы матрицы корреляции являются скалярными произведениями векторов (грамиан на векторах). Значения главной диагонали отражают квадрат длины данных векторов. Значения матрицы не нормированы (обычно их нормируют, но для наших целей этого не нужно). Размерность матрицы корреляции совпадает с количеством исходных точек (векторов).

Теперь переставим перемножаемые в (8.1) матрицы местами и получим матрицу ковариации (опять же опускаем множитель 1/(1-n), которым обычно нормируют значения ковариации):

Здесь результат выражен в характеристиках. Соответственно, размерность матрицы ковариации равна количеству исходных характеристик (компонент). Для двух характеристик матрица ковариации имеет размерность 2×2, для трех — 3×3 и т.д.

Почему важна размерность матриц корреляции и ковариации? Фишка в том, что поскольку матрицы корреляции и ковариации происходят из произведения одного и того же набора векторов, то они имеют один и тот же набор собственных чисел, один и тот же ранг (количество независимых размерностей) матрицы. Как правило, количество векторов (точек) намного превышает количество компонент. Поэтому о ранге матриц судят по размерности матрицы ковариации.

Диагональные элементы ковариации отражают дисперсию компонент. Как мы видели выше, дисперсия и собственные числа тесно связаны. Поэтому можно сказать, что в первом приближении собственные числа матрицы ковариации (а значит, и корреляции) равны диагональным элементам (а если межкомпонентная дисперсия отсутствует, то равны в любом приближении).

Если стоит задача найти просто спектр матриц (собственные числа), то удобнее ее решать для матрицы ковариации, поскольку, как правило, их размерность небольшая. Но если нам необходимо найти еще и собственные вектора (определить собственную систему координат) для исходного набора, то необходимо работать с матрицей корреляции, поскольку именно она отражает скалярное произведение векторов.

Отметим, что метод главных компонент как раз и состоит в расчете спектра матрицы ковариации/корреляции для заданного набора векторных данных. Найденные компоненты спектра располагаются вдоль главных осей эллипсоида данных. Из нашего рассмотрения это вытекает потому, что главные оси — это и есть те оси, дисперсия (разброс) данных по которым максимален, а значит, и максимально значение спектра.

Правда, могут быть и отрицательные дисперсии, и тогда аналогия с эллипсоидом уже не очевидна.

Видео:Теория вероятностей #19: ковариация, корреляция, зависимость двух случайных величинСкачать

9. Матрица Грина — это матрица корреляции векторов

Рассмотрим теперь ситуацию, когда нам известен не набор чисел, характеризующих точки (элементы), а набор расстояний между точками (причем между всеми). Достаточно ли данной информации для определения ССК (собственной системы координат) набора?

Ответ дан в первой части — да, вполне. Здесь же мы покажем, что построенная по формуле (1.3′) матрица Грина и определенная выше матрица корреляции векторов (8.1) — это одна и та же матрица.

Как такое получилось? Сами в шоке. Чтобы в этом убедиться, надо подставить выражение для элемента матрицы квадратов расстояний

в формулу преобразования девиации:

Отметим, что среднее значение матрицы квадратов расстояний отражает дисперсию исходного набора (при условии, что расстояния в наборе — это сумма квадратов компонент):

Подставляя (9.1) и (9.3) в (9.2), после несложных сокращений приходим к выражению для матрицы корреляции (8.1):

Итак, матрица Грина и матрица корреляции векторов — суть одно и то же. Ранг матрицы корреляции совпадает с рангом матрицы ковариации (количеством характеристик — размерностью пространства). Это обстоятельство позволяет строить спектр и собственную систему координат для исходных точек на основе матрицы расстояний.

Для произвольной матрицы расстояний потенциальный ранг (количество измерений) на единицу меньше количества исходных векторов. Расчет спектра (собственной системы координат) позволяет определить основные (главные) компоненты, влияющие на расстояния между точками (векторами).

Таким образом можно строить собственные координаты элементов либо на основании их характеристик, либо на основании расстояний между ними. Например, можно определить собственные координаты городов по матрице расстояний между ними.

Видео:Угол между векторами. 9 класс.Скачать

Геометрическая основа корреляционного анализа

Геометрическая основа корреляционного анализа

Корреляционный анализ результатов эксперимента получил достаточно широкое распространение в геодезической теории (см., например [1]) и практике [2], [3] и др. Традиционно используют следующие коэффициенты корреляции:

– парный rij, показывающий тесноту связи между i и j рядами, игнорируя влияние других;

– частный rij|k…, показывающий тесноту связи между i и j рядами при условии учета линейного влияния всех других рядов;

– множественный rj|…, показывающий тесноту связи между i рядом и всеми остальными.

Для более качественного анализа целесообразно вычислять не отдельные коэффициенты, а всю их совокупность в виде матрицы. Тем более, что существует много программных пакетов, позволяющих быстро и просто манипулировать с матрицами как с объектами. Один из способов получения перечисленных выше коэффициентов – через использование центрированной матрицы Ац, полученной из матрицы результатов эксперимента А (матрицы плана). Центрирование строится в виде отклонения от среднего по столбцам, для каждого столбца из А. По центрированной матрице Ац вычисляется нормальная матрица K = AцT × Ац/ n (матрица эмпирических моментов, выборочная ковариационная матрица), и обратная к ней Q = K -1. Тогда перечисленные выше коэффициенты корреляции в виде матриц можно легко получить следующим образом [5]:

Здесь

– частные коэффициенты корреляции

т. е. совершенно эквивалентно по форме как и парные, но по элементам обратной матрицы Q. Матрица D¢ также строится по элементам матрицы Q, аналогично D;

Здесь

Достаточно давно известно (см., например [4]), что парный коэффициент корреляции rxy между двумя рядами х и у

есть косинус угла b между центрированными векторами vx и vy. Из (4) следует, что

Рис. 1. Графическое представление парного коэффициента корреляции

Некоторые другие возможности получения парного коэффициента корреляции на основе рис. 1 и формул тригонометрии, смотри [5].

Принимая вектора vx и vy как подпространства размерности (п´1) в общем пространстве (п´п), трактовку меры статистической связи в виде коэффициента корреляции как косинуса угла между этими подпространствами можно легко расширить и на более общие подпространства, чем вектора.

Рассматривая угол между двумя подпространствами в виде плоскостей j и l (см. рис.2), заметим, что угол b между ними есть наименьший из всех возможных углов, образованных линией пересечения плоскостей и перпендикулярами.

Но линия пересечения плоскостей и перпендикуляры образуют два ортогональных базиса: ЕСВ для плоскости j и DCB для плоскости l с одной общей осью АВ. Угол b есть угол между не общими осями ортогональных базисов. Расширяя аналогию на гиперплоскости (т. е. подпространства размерности (п´k) пространства размерности (п´n) c п>k ), угол между любыми подпространствами может трактоваться как наименьший угол между не совпадающими осями в объединенном базисе для нового объекта, являющегося пересечением этих подпространств. Если подпространства предварительно центрировать, то, как показано выше, косинус угла между преобразованными подпространствами должен быть, по сути, некоторым аналогом коэффициента корреляции.

|

Рис. 2. Определение угла между плоскостями

Обобщая сказанное, процедуру получения угла между подпространствами для вычисления аналога коэффициента корреляции можно свести к следующим шагам:

1. Центрирование векторов xi, описывающих процесс с получением новых векторов (vx)i ;

2. Выделение в общем пространстве процесса подпространств F и L между которыми определяется степень статистической связи по предложенной процедуре, а в них ортогональных базисов ВF и ВL;

3. Объединение этих базисов в одну структуру по общим осям

B = ВF È ВL;

4. Выделение всех полученных углов между не общими осями разных базисов, кроме прямых;

5. Нахождение минимального угла из всех углов, полученных в пункте 4.

Основой для выделения и объединения базисов в подпространствах может служить процедура сингулярного разложения при представлении подпространств в виде матриц [4].

Не смотря на кажущуюся громоздкость последовательности, она очень легко реализуема практически в любой программной среде, имеющей стандартную процедуру сингулярного разложения, например в оболочке MATLAB.

Из линейной алгебры известно, что выделить ортогональные базисы можно используя, например, сингулярное разложение, а объединение структур с общими частями произвести путем свертки по общим частям, или перемножением транспонированной и прямой матриц задающих подпространства F и L:

Для случая анализа связи двух векторов vx и vy ортогональные базисы для них есть вектора их направляющих косинусов

Объединение в общую структуру дает

формулу идентичную (4), т. е. сразу косинус угла между векторами vx и vy (так как он один), или коэффициент корреляции rxy.

Рассмотрим все возможные комбинации векторов для определения тесноты связи между ними, посредством угла между подпространствами, которые эти комбинации образуют. Пусть процесс описан матрицей

Косинус угла между одним вектором ai и группой других векторов, образующих подпространство

При определении множественного коэффициента корреляции нельзя чтобы вектор ai принадлежал другому подпространству

Следующая группа комбинаций подразумевает наличие общих частей в подпространствах. Если в одном и другом подпространстве не общие только два вектора ai и aj, то можно ожидать, что другие, общие, «компенсируют» друг друга. Косинус угла между такими подпространствами, по определению, будет частным коэффициентом корреляции rij|…. Например, для процесса определяемого тремя векторами

Последняя группа комбинаций включает два подпространства из не единичного набора векторов и не имеющая общих частей subspace(

Этим набором исчерпываются традиционные величины, характеризующие меру тесноты статистической связи между векторами, известные как разного рода коэффициенты корреляции. Предложенный подход на основе понятия угла между подпространствами позволяет не только объединить их определение в едином алгоритме, но, что более важно, расширить, т. е. ввести некоторые новые меры тесноты связи. В первую очередь к ним можно отнести меры на основе угла между частично пересекающимися группами (т. е. имеющих несколько общих) векторов. Так как здесь участвуют группы, то может быть имеет смысл такой класс мер тесноты связи назвать групповыми. С другой стороны эти меры не являются в привычном смысле коэффициентами корреляции. Поэтому их можно назвать просто коэффициентами связанности.

Введенная мера групповой связанности в первом и втором подпространствах имеет группу общих векторов и две группы не общих векторов. Этим она похожа на частный коэффициент корреляции при условии одного не общего вектора в первой группе и одного во второй. В более общем случае предложенная мера определяет тесноту связи между подпространством

Выявление тесноты связи на основе углов между подпространствами в виде предложенных разных коэффициентов связанности позволяет очень сильно расширить возможности анализа внутренних связей между структурами, описывающими исследуемые процессы в геодезии, экологии, других науках о Земле. В рамках единого алгоритма, который очень легко программируется возможно перебрать и проанализировать связи в составляющих процесса по следующим группам:

– между i— тым и j—тым векторами в процессе при игнорировании влияния остальных;

– между i— тым и j—тым векторами в процессе при учете линейного влияния всех остальных;

– между i— тым и j—тым векторами в процессе при учете линейного влияния выделенной группы из всех остальных;

– между первой и второй группами не перекрывающихся векторами в процессе;

– между первой и второй группами в процессе с учетом влияния третьей группы векторов.

На основе предложенного подхода также возможна кластеризация по всем мерам при заданных границах кластера.

Проведем численные исследования предложенного подхода. Для этого используем результаты экологического мониторинга на территории санитарно-защитной зоны города Новополоцка по следующим параметрам: уровень грунтовых вод, характеристика солнечной активности в числах Вольфа, количество осадков за вегетационный период и за год, температура за вегетационный период, радиальный прирост поздней и ранней древесины ели (см. табл. 1). Наблюдения брались за период от 1975 до 2000 годов включительно. Вычислим парные, частные и множественные коэффициенты корреляции на основе традиционных формул (1), (2) и (3), а затем проверим их на основе получения углов между соответствующими подпространствами. В заключение получим значения некоторых групповых коэффициентов связанности.

Корреляционная матрица из (1) по данным табл. 1 есть

матрица частных коэффициентов корреляции по (2)

Результаты экологического мониторинга по 7 составляющим

🌟 Видео

Коэффициент корреляции. Дискретное распределениеСкачать

КОРРЕЛЯЦИЯ Спирмена Пирсона Кенделла | АНАЛИЗ ДАННЫХ #12Скачать

Коэффициент корреляции: заблуждение и неочевидные выводыСкачать

Коэффициенты корреляции в ExcelСкачать

Коэффициент корреляции. ТемаСкачать

Коэффициент корреляции ПирсонаСкачать

Математика #1 | Корреляция и регрессияСкачать

Видеоурок: Расчет коэффициента корреляцииСкачать

Коэффициент ФехнераСкачать

Коэффициент корреляции ПирсонаСкачать

Коэффициент корреляции - Борис МиркинСкачать

Коэффициент ранговой корреляции Спирмена в MS Excel. Функция РАНГ.СРСкачать

Коэффициент корреляции. Статистическая значимостьСкачать

Множественный и частные коэффициенты корреляцииСкачать

Корреляция и ковариация двумерной случайной величиныСкачать