- Инструменты сайта

- Основное

- Навигация

- Информация

- Действия

- Содержание

- Евклидово пространство

- Определения

- Свойства

- Ортогонализация

- Матричный формализм алгоритма Грама-Шмидта: QR-разложение

- Расстояние от точки до многообразия

- Вычисление расстояния

- Угол между вектором и линейным многообразием

- Свойства матрицы Грама

- Задачи

- Источник

- Расчет евклидова расстояния с помощью NumPy

- Что такое евклидово расстояние?

- Математическая формула

- Использование встроенной системы math.dist()

- Заключение

- Вычислить расстояние между двумя векторами разной длины

- ОТВЕТЫ

- Ответ 1

- Ответ 2

- Ответ 3

- 📺 Видео

Инструменты сайта

Основное

Навигация

Информация

Действия

Содержание

Видео:Определение кратчайшего расстояние между скрещивающимися прямыми методом замены плоскостей проекцииСкачать

Евклидово пространство

Одной из важнейших задач геометрии является задача измерения расстояния между двумя объектами. В произвольном линейном пространстве мы пока не можем определить насколько «близки» между собой объекты. В настоящем разделе понятие расстояния между двумя векторами — элементами линейного пространства — будет вводиться посредством скалярного произведения векторов. Насколько обоснован такой порядок введения понятий:

$ mbox qquad $ скалярное произведение $ to $ длина ?

Ведь в аналитической геометрии последовательность кажется более «естественной»: скалярное произведение двух векторов $ X_ $ и $ Y_ $ определялось как произведение длин этих векторов на косинус угла между ними: $ langle X,Y rangle = |X| cdot |Y| cdot cos (widehat) $. Тем не менее, формально непротиворечива и обратная схема: если допустить, что скалярное произведение любых двух векторов может быть как-то вычислено (например, в $ mathbb R^ $ по формуле $ langle X,Y rangle = x_1y_1+x_2y_2+x_3y_3 $ при заданных прямоугольных координатах $ (x_1,x_2,x_3) $ и $ (y_1,y_2,y_3) $ векторов $ X_ $ и $ Y_ $), то и длину векторов и угол между ними можно выразить через подходящие скалярные произведения: $$ |X|=sqrt,qquad widehat=arccos frac<sqrt> .$$

Видео:Видеоурок "Расстояние между прямыми в пространстве"Скачать

Определения

Вещественное линейное пространство $ mathbb E_ $ называется евклидовым 1) , если в этом пространстве определена функция, ставящая в соответствие паре векторов $ subset mathbb E $ вещественное число, называемое скалярным произведением векторов 2) $ X_ $ и $ Y_ $, и обозначаемое $ langle X,Y rangle_ $ или $ (X,Y)_ $; при этом фцнкция подчиняется аксиомам:

1. $ langle X,Y rangle= langle Y,X rangle $ для $ subset mathbb E $;

2. $ langle X_1+X_2,Y rangle = langle X_1,Y rangle + langle X_2,Y rangle $ для $ subset mathbb E $;

3. $ langle lambda, X,Yrangle=lambda, langle X,Yrangle $ для $ subset mathbb E, lambda in mathbb R $;

4. $ langle X,X rangle>0 $ для $ forall Xne mathbb O $, $ langle mathbb O,mathbb O rangle =0 $.

Из аксиом 1 и 2 вытекает свойство линейности скалярного произведения и по второму вектору:

2′. $ langle X,Y_1+Y_2 rangle = langle X,Y_1 rangle + langle X,Y_2 rangle $ для $ subset mathbb E $.

Пример 1. Пространство $ mathbb R_^ $, рассматриваемое как пространство вещественных векторов-столбцов. Для векторов

$$ X=left[begin x_1 \ vdots \ x_n end right] quad mbox quad Y=left[begin y_1 \ vdots \ y_n end right] $$ их скалярное произведение определим обобщением привычной из геометрии формулы $$ langle X,Y rangle = sum_^n x_jy_j = X^Y ; $$ в последней формуле $ ^ $ означает транспонирование. Будем называть это скалярное произведение стандартным. Легко проверить выполнимость аксиом 1 — 4 .

Однако стандартное определение скалярного произведения вовсе не является единственно допустимым; формально скалярное произведение можно ввести и другим способом. Рассмотрим (пока произвольную) вещественную квадратную матрицу $ A_ $ порядка $ n_ $ и положим $$ begin langle X,Y rangle = X^ A Y & = & a_x_1y_1+a_x_1y_2+ dots + a_x_1y_n &+ \ &+&a_x_2y_1+a_x_2y_2+ dots + a_x_2y_n &+ \ &+& dots &+ \ &+&a_x_ny_1+a_x_ny_2+ dots + a_x_ny_n & . end $$ (Здесь векторы $ X_ $ и $ Y_ $ из $ mathbb R_^ $ снова рассматриваются как столбцы.) Если матрица $ A_ $ является положительно определенной, то все аксиомы скалярного произведения будут удовлетворены.

Зачем нужна такая возможность в неоднозначности определения скалярного произведения в одном и том же пространстве? — Ответ на этот вопрос откладывается до следующего пункта. А пока приведу одно замечание 3) .

Пример 2. Пространство $ mathbb P_ $ полиномов одной переменной степеней $ le n_ $ с вещественными коэффициентами. Скалярное произведение полиномов

$$ p(x)=a_x^n+a_1x^+dots + a_n quad mbox quad q(x)=b_x^n+b_1x^+dots + b_n $$ введем формулой $$ langle p(x), q(x) rangle = sum_^n a_j b_j. $$ Легко проверить справедливость всех аксиом.

В том же пространстве $ mathbb P_ $ можно ли определить скалярное произведение формулой

$$ langle p(x),q(x) rangle = sum_^m p(x_k) q(x_k) quad npu _^m subset mathbb R ? $$

Пример 3. Линейное пространство $ mathbb R^ $ вещественных квадратных матриц порядка $ n_ $. Скалярное произведение введем формулой

Вторая интерпретация формулы связана с операцией $ operatorname $ нахождения следа матрицы, т.е. суммы элементов ее главной диагонали: $$ langle A,B rangle = operatorname left(Acdot B^ right) , . $$ Эквивалентность последнего представления определению устанавливается непосредственной проверкой.

На основании аксиом скалярного произведения, его вычисление для произвольных векторов $ X_ $ и $ Y_ $ может быть сведено к вычислению скалярных произведений векторов произвольного базиса. В самом деле, если система $ <X_1,dots,X_> $ составляет базис пространства $ mathbb E $, то, разложив оба вектора по этому базису $$X=x_1X_1+ dots +x_nX_n quad u quad Y=y_1X_1+ dots +y_nX_n , $$ получаем: $$langle X,Y rangle=langle x_1X_1+ dots +x_nX_n , y_1X_1+ dots +y_nX_n rangle=$$ $$ = left< begin &&x_1y_1 langle X_1,X_1 rangle + x_1y_2 langle X_1,X_2 rangle + dots + x_1y_n langle X_1,X_n rangle + \ &+&x_2y_1 langle X_2,X_1 rangle + x_2y_2 langle X_2,X_2 rangle + dots + x_2y_n langle X_2,X_n rangle+ \ &+ & dots qquad + \ &+&x_ny_1 langle X_n,X_1 rangle + x_ny_2 langle X_n,X_2 rangle + dots + x_ny_n langle X_n,X_n rangle end right> = $$ $$ =(x_1,x_2,dots,x_n)left( begin langle X_1,X_1 rangle & langle X_1,X_2 rangle & dots & langle X_1,X_n rangle \ langle X_2,X_1 rangle & langle X_2,X_2 rangle & dots & langle X_2,X_n rangle \ dots & & & dots \ langle X_n,X_1 rangle & langle X_n,X_2 rangle & dots & langle X_n,X_n rangle end right) left(begin y_1 \ y_2 \ vdots \ y_n endright) . $$ Итак, при изменении векторов $ X_ $ и $ Y_ $ в последней формуле изменятся лишь строка и столбец координат, а промежуточная матрица останется неизменной. Задание этой матрицы, следовательно, полностью определит скалярное произведение в $ mathbb E_ $. Фактически задание скалярного произведения в разобранном выше примере пространства $ mathbb R^ $ по формуле $ langle X,Y rangle=X^AY $ можно рассматривать именно как частный случай этого при подходящем подборе базисных векторов. Согласно рассуждениям из примера $ 1_ $, матрица $$ left( begin langle X_1,X_1 rangle & langle X_1,X_2 rangle & dots & langle X_1,X_n rangle \ langle X_2,X_1 rangle & langle X_2,X_2 rangle & dots & langle X_2,X_n rangle \ dots & & & dots \ langle X_n,X_1 rangle & langle X_n,X_2 rangle & dots & langle X_n,X_n rangle end right) $$ должна обладать некоторыми принципиальными свойствами. Так оно и окажется, см. ☟ НИЖЕ.

Матрицей Грама системы векторов 4) $ <X_1,dots,X_> $ называется квадратная матрица $$ G(X_1,dots,X_m)=left( begin langle X_1,X_1 rangle & langle X_1,X_2 rangle & dots & langle X_1,X_m rangle \ langle X_2,X_1 rangle & langle X_2,X_2 rangle & dots & langle X_2,X_m rangle \ dots & & & dots \ langle X_m,X_1 rangle & langle X_m,X_2 rangle & dots & langle X_m,X_m rangle end right) = left[ (X_j,X_k) right]_^m . $$ Ее определитель называется определителем Грама 5) (или грамианом) системы векторов $ <X_1,dots,X_> $: $$ (X_1,dots,X_m)=left| begin langle X_1,X_1 rangle & langle X_1,X_2 rangle & dots & langle X_1,X_m rangle \ langle X_2,X_1 rangle & langle X_2,X_2 rangle & dots & langle X_2,X_m rangle \ dots & & & dots \ langle X_m,X_1 rangle & langle X_m,X_2 rangle & dots & langle X_m,X_m rangle end right| = det left[ langle X_j,X_k rangle right]_^m . $$

С помощью матрицы Грама формула скалярного произведения записывается в виде $$ langle X,Y rangle =[x_1,dots,x_n] G(X_1,dots,X_n) left[ begin y_1 \ vdots \ y_n end right] . $$

Пример 4. В пространстве $ mathbb R^ $ столбцов из $ n_ $ элементов при стандартном способе задания скалярного произведения

$$ langle X,Y rangle = sum_^n x_jy_j quad npu quad X=[x_1,dots,x_n]<^>, Y=[y_1,dots,y_n]<^> $$ матрицу Грама системы векторов $ <X_j=[x_,x_,dots,x_]^ >_^m $ можно представить в виде произведения матриц $$ G(X_1,dots,X_)=left( begin x_ & x_ & dots & x_ \ x_ & x_ & dots & x_ \ dots & & & dots \ x_ & x_ & dots & x_ end right) left( begin x_ & x_ & dots & x_ \ x_ & x_ & dots & x_ \ vdots & & & vdots \ x_ & x_ & dots & x_ end right) . $$ Произведение имеет вид $ Mcdot M^ $ и, согласно теореме Бине-Коши, определитель этого произведения равен $ 0_ $ при $ m>n_ $ и неотрицателен при $ m le n $. НИЖЕ будет установлено, что обнаруженные свойства определителя Грама являются универсальными: они выполняются в произвольном евклидовом пространстве. См. также, «обращение» этого результата — задача 4 ☞ ЗДЕСЬ.

Видео:19. Расстояние между параллельными прямыми Расстояние между скрещивающимися прямымиСкачать

Свойства

Теорема. Имеет место неравенство Коши–Буняковского:

$$ langle X,Y rangle ^2 le langle X,X rangle langle Y,Y rangle quad npu forall subset mathbb E . $$

Доказательство для случая $ mathbb R^_ $ приведено ☞ ЗДЕСЬ. Для доказательства общего случая используем одну вспомогательную конструкцию. Из аксиомы 4 следует, что для $ forall lambda in mathbb R $ будет выполнено $ langle lambda, X — Y,, lambda, X — Y rangle ge 0 $. Имеем: $$ 0 le langle lambda, X — Y,, lambda, X — Y rangle le lambda^2 langle X,X rangle — 2,lambda langle X,Y rangle +(Y,Y) . $$ Квадратное относительно $ lambda_ $ неравенство будет выполнено при всех вещественных значениях этого параметра тогда и только тогда, когда дискриминант квадратного трехчлена будет отрицателен: $$ mathcal D=langle X,Y rangle^2 — langle X,X rangle langle Y,Y rangle le 0 . $$ ♦

С помощью скалярного произведения, введенного в предыдущем пункте, можно доказать справедливость интегральной формы неравенства:

$$ left( int_a^b p(t)q(t) d,t right)^2 le int_a^b p^2(t) d,t cdot int_a^b q^2(t) d,t $$ для произвольных полиномов 6) $

subset mathbb R [x] $.

Длиною вектора $ X_ $ в евклидовом пространстве $ mathbb E_ $ называется число $$ |X| = sqrt ; $$ здесь квадратный корень понимается как корень арифметический: $ |X| ge 0 $. Расстоянием между векторами $ X_ $ и $ Y_ $ называется число $ |X-Y| $.

В $ mathbb R^_ $ при скалярном произведении, заданном стандартным способом формулой

$$ langle X,Y rangle = sum_^n x_jy_j quad npu quad X=[x_1,dots,x_n]<^>, Y=[y_1,dots,y_n]<^> , $$ длина вектора $ X_ $ определяется естественным (с точки зрения геометрии) способом: $ |X|=sqrt $.

С помощью введенного определения неравенство Коши-Буняковского можно переписать в виде $$ |langle X,Y rangle| le |X| cdot |Y| quad npu forall subset mathbb E , $$ где $ | cdot | $ в левой части означает модуль, а в правой части — длину.

Теорема. Имеет место неравенство треугольника

$$ |X+Y| le |X|+|Y| quad npu forall subset mathbb E . $$

Доказательство. На основании неравенства Коши-Буняковского, имеем: $$ 0 le langle X+Y,, X+Y rangle=langle X,X rangle+2langle X,Y rangle+langle Y,Y rangle le |X|^2+2, |X| cdot |Y| +|Y|^2=left(|X|+|Y| right)^2 . $$ ♦

Углом между векторами $ X_ $ и $ Y_ $ называется угол $$varphi = widehat = arccos frac .$$ Ввиду неравенства Коши-Буняковского это определение непротиворечиво: дробь под знаком арккосинуса не превосходит 1 по абсолютной величине. Векторы $ X_ $ и $ Y_ $ называются ортогональными: $ X bot Y $ если угол между ними равен $ pi/2 $, или, что то же, $ langle X,Y rangle=0 $.

Введенное таким определением понятие является естественным обобщением понятия угла на плоскости и в трехмерном пространстве. Хотя в пространствах размерностей больших $ 3_ $ человеческие мозги думать не приучены, тем не менее, абстракция находит практическое применение в задаче информационного поиска.

Пусть задача заключается в сравнении двух текстовых документов «на похожесть». Имеются некоторые наборы ключевых слов, описывающих каждый из этих документов. Составим объединение этих наборов, упорядочим получившийся набор (пронумеруем слова), посчитаем частоты вхождений каждого из слов в каждый из документов. Получим два вектора: $$ X_1=(f_,f_,dots), X_2=(f_,f_,dots) , $$ описывающие каждый из документов. Здесь $ f_ in $ — количество вхождений $ k_ $-го слова в $ j_ $-й документ. Для оценки близости векторов, на первый взгляд, кажется естественным вычислить расстояние между ними стандартным способом: $$ |X_1-X_2| = sqrt < sum_(f_-f_)^2> . $$ Однако, по здравому размышлению, понимаем, что при таком способе, документы различные по объему (общему количеству слов) будут слишком сильно отличаться друг от друга, при том, что могут оказаться близкими по сути (как будет отличаться большая статья от собственного реферата). Поэтому имеет смысл усреднить частоты в обоих текстах, т.е. рассматривать расстояние между векторами $ X_1/|X_1| $ и $ X_2/|X_2| $ единичной длины: $$ left|frac-fracright| = sqrt<2left( 1- frac right)> ; $$ скалярное произведение под знаком корня вычисляется стандартным способом: $ langle X_1,X_2 rangle=sum_ f_f_ $. Отсюда и возникает понятие косинусного расстояния: величина $$ frac $$ неотрицательна (поскольку компоненты векторов $ X_1,X_2 $ неотрицательны), и чем ближе она к $ 1_ $ тем меньше расстояние между между нормированными векторами. Эта величина называется также похожестью или cходством 8) векторов (документов) $ X_ $ и $ X_ $.

Теорема [Пифагор]. Если $ X bot Y $, то $ |X+Y|^2=|X|^2+|Y|^2 $.

Если векторы $ X_1,dots,X_k $ попарно взаимно ортогональны, то

Пример. Найти расстояние между полиномами

$$p(x)=x^-1/2,x^-1/2,x^+5,x^-5,x^+5,x^2+1 quad u quad q(x)=5,x^2+1 $$ если скалярное произведение задается формулой а) $ displaystyle langle p(x), q(x) rangle = sum_^ a_j b_j $ ; б) $ displaystyle langle p(x), q(x) rangle = int_^1 p(t)q(t) d, t $.

Решение. Для случая а) нам достаточно просто вычислить сумму квадратов коэффициентов разности $ p(x)-q(x) $: расстояние равно $ sqrt $.

Для случая б) нам придется иметь дело с интегралом $$ int_^1 left(p(t)-q(t) right)^2 d, t = int_^1 left(t^-1/2,t^-1/2,t^+5,t^-5,t^ right)^2 d, t , $$ который, несмотря на свой громоздкий вид, может быть вычислен элементарными приемами математического анализа. В этом случае расстояние будет равно $ sqrt $.

Ответ. а) $ approx 7.176 $ ; б) $ approx 0.076 $.

Теперь прокомментируем последний пример. В разделе, посвященном полиному одной переменной, имеется теорема о непрерывной зависимости корней полинома от его коэффициентов. Смысл этого результата в следующем: если коэффициенты полиномов

$$f(x)=x^n+a_1x^+dots+a_n quad u quad (x)=x^n+_1x^+dots+_n$$ из $ mathbb C[x] $ близки, то и корни этих полиномов (при соответствующей нумерации) будут близки на комплексной плоскости. В этой теореме мера близости полиномов оценивается по формуле $$ sqrt[n]<sum_^n|a_k-_k| gamma^ > quad npu quad gamma = max_<jin > left( sqrt[j] , sqrt[j]<|_j|> right) , $$ которая, хоть и не совпадает с формулой $$ sqrt<sum_^n left(a_k-_k right)^2> , $$ определяющей расстояние в пространстве полиномов, но идейно ей близка. Вычисленное в предыдущем примере расстояние между полиномами $ p_(x) $ и $ q_(x) $ по формуле а) оказывается достаточно большим в том смысле, что если для полинома $ p_(x) $ искать полином, имеющий почти такое же расположение корней на $ mathbb C_ $, то полином $ q_(x) $ окажется неподходящим кандидатом. 9)

Другое дело, если ставится задача приближения полинома $ p_(x) $ только на интервале $ [-1,1] $ — тогда полином $ q_(x) $ может оказаться вполне полезным. Выясним сначала природу интеграла, возникшего при решении. Пусть сначала $ p_(x) $ и $ q_(x) $ — произвольные, но (для простоты рассуждений) неотрицательные на интервале $ [a_,b] $ полиномы. Геометрический смысл интеграла $ int_a^b p(t) d, t $ — площадь криволинейной трапеции на плоскости $ (x_,y) $, ограниченной прямыми $ x=a_,,x=b,,y=0 $ и графиком $ y=p(x) $. Следовательно, геометрический смысл интеграла $$ int_a^b left| p(t)-q(t) right| d, t $$ — площадь фигуры, ограниченной прямыми $ x=a,,x=b_ $ и графиками $ y=p(x), y=q(x) $

Подводя итог приведенным рассуждениям, можно только повторить: метод, выбираемый для оценки близости между объектами, может зависеть от поставленной задачи. Микроскоп не пригоден для наблюдения за большими объектами, а телескоп — за малыми.

Следующий результат также имеет название, взятое из планиметрии, где он формулируется так: сумма квадратов длин диагоналей параллелограмма равна сумме квадратов длин его сторон.

Теорема. В евклидовом пространстве имеет место равенство параллелограмма

$$ |X+Y|^2+|X-Y|^2 =2(|X|^2+|Y|^2) quad npu forall subset mathbb E . $$

Видео:Расстояние между точкамиСкачать

Ортогонализация

Пусть $ dim mathbb E=n $ и векторы $ $ составляют базис $ mathbb E_ $. Этот базис называется ортогональным если векторы попарно ортогональны: $ X_jbot X_k $; базис называется нормированным если каждый его вектор имеет единичную длину: $ |X_j|=1 $; базис называется ортонормированным если он ортогонален и нормирован, т.е. $$langle X_j,X_k rangle=delta_ ,quad npu quad subset .$$ Здесь $ delta_^ $ — символ Кронекера.

Ортогональный базис будем обозначать $ _1,dots, _n $.

Чему равно расстояние между двумя векторами ортонормированного базиса?

В пространстве $ mathbb R_^ $ стандартным ортогональным базисом является базис, состоящий из векторов $$ _j = big[underbrace_,0,dots,0big]^ quad npu quad j in . $$ Существование же ортогонального базиса в произвольном евклидовом пространстве еще требует доказательства. Предварительно установим следующий результат.

Теорема. Если ненулевые векторы $ X_1,dots, X_ $ попарно ортогональны, то они линейно независимы.

Доказательство. В самом деле, если $$ lambda_1 X_1 + dots + lambda_n X_n = mathbb O , $$ то, домножив это равенство скалярно на $ X_ $, получим $$ lambda_1 langle X_1,X_1 rangle + dots + lambda_n langle X_1,X_n rangle = 0 . $$ Поскольку $ langle X_1,X_j rangle=0 $ для $ jin $, то $ lambda_1 langle X_1,X_1 rangle=0 $, откуда $ lambda_1=0 $. Аналогично показывается, что и все остальные $ lambda_j $ равны 0. ♦

Задача. Пусть имеется произвольная система $ $ линейно независимых векторов. Требуется построить систему ортогональных векторов $ left<_1,dots, _k right> $ такую, чтобы линейные оболочки любых подсистем совпадали: $$ left(X_1,dots,X_m right) =left(_1,dots, _m right) quad npu quad min . $$ Иными словами, вектор $ _1 $ должен линейно зависеть от $ X_ $, вектор $ _2 $ должен линейно выражаться через $ X_1,X_2 $, $ _3 $ — через $ X_1,X_2,X_3 $ и т.д.

Алгоритм ортогонализации Грама — Шмидта 10)

В случае $ m_=1 $ возьмем $ _1=X_1 $: поскольку вектор $ X_ $ входит в линейно независимую систему , то $ _1 ne mathbb O $. Далее, будем искать $ _2 $ в виде $$_2=X_2 + alpha_ _1 $$ при пока неопределенном коэффициенте $ alpha_ $. Очевидно, что при таком выборе $ _2 $ условие $ (X_1,X_2)=(_1,_2) $ будет выполнено. Подберем $ alpha_ $ так, чтобы выполнялось $ _2 bot _1 $. $$0=langle _1,_2 rangle=langle _1,X_2 rangle+alpha_ langle _1,_1 rangle Rightarrow alpha_=-langle _1,X_2 rangle big/ langle _1,_1 rangle . $$ Таким образом, коэффициент $ alpha_ $, а вместе с ним и вектор $ _2 $ определяются единственным образом. При этом $ _2ne mathbb O $, ибо, в противном случае, векторы $ X_2 $ и $ _1=X_1 $ были бы л.з., что противоречит предположению о линейной независимости системы $ $. Продолжаем процесс далее: вектор $ _3 $ ищем в виде $$_3=X_3 + alpha_ _1 + alpha_ _2 $$ при пока неопределенных коэффициентах $ alpha_ $ и $ alpha_ $. Условие $ (X_1,X_2,X_3)=(_1,_2,_3) $ выполняется поскольку $$alpha_ _1 + alpha_ _2 in (X_1,X_2) subset (X_1,X_2,X_3) .$$ Подберем скаляры $ alpha_ $ и $ alpha_ $ так, чтобы выполнялось $ _3 bot _1 $ и $ _3 bot _2 $. Два этих условия задают систему линейных уравнений $$left< begin langle X_3,_1 rangle + alpha_ langle _1, _1 rangle + alpha_ langle _2 , _1 rangle &=0 ,\ langle X_3,_2 rangle + alpha_ langle _1, _2 rangle + alpha_ langle _2 , _2 rangle &=0 , end right. iff begin alpha_=-langle X_3,_1 rangle big/ |_1|^2 \ alpha_=-langle X_3,_2 rangle big/ |_2|^2 end $$

Процесс продолжается далее аналогично. Допустим, что векторы $ _1,dots,_ $ уже построены, они ненулевые, попарно ортогональные и $$ left(X_1,dots,X_ right)= left(_1,dots, _ right) .$$ Вектор $ _ $ ищем в виде: $$ _ =X_k+alpha_ _1 + alpha_ _2 +dots + alpha_ _ $$ при пока неопределенных коэффициентах $ alpha_,dots ,alpha_ $. Условие $ left(X_1,dots,X_,X_k right)= left(_1,dots, _,_ right) $ выполнено и, кроме того, $ _ne mathbb O $ (в противном случае $ X_k in left(_1,dots, _ right) =left(X_1,dots,X_ right) $, т.е. система $ <X_1,dots,X_,X_k > $ линейно зависима. Коэффициенты $ alpha_, dots ,alpha_ $ подбираются из условий $ _ bot _1,dots, _ bot _ $. Получающаяся система линейных уравнений имеет единственное решение $$alpha_=- langle X_k,_1 rangle big/ |_1|^2 ,dots, alpha_=-langle X_k,_ rangle big/ |_|^2 , $$ и это решение определяет единственный вектор $ _ $. ♦

Пример. Ортогонализовать систему векторов

$$ X_1=left[1,0,0,0,1 right], X_2=left[1,1,0,1,1 right], X_3=left[1,1,1,1,1 right] $$ при стандартном способе задания скалярного произведения в $ mathbb R^5 $.

Пример. Пусть в пространстве полиномов скалярное произведение задается формулой

$$ langle p(x),q(x) rangle=int_^ p(t)q(t) d, t .$$ Построить ортогональный базис этого пространства.

Решение. Искомый базис строится ортогонализацией канонического базиса $ 1,x,x^2,dots, x^n $. В результате получаем систему полиномов: $$1, x, x^2-frac, x^3-frac, x, x^4-frac, x^2+frac,dots $$ Полиномы, получающиеся из этих нормированием: $$P_0(x)=1, P_1(x)= x, P_2(x)=frac(3,x^2-1), P_3(x)= frac( 5,x^3-3, x), $$ $$ P_4(x)= frac(35,x^4-30, x^2+3),dots $$ $$ P_n(x)=frac sum_^ frac x^ $$ известны как полиномы Лежандра. Здесь $ lfloor mbox rfloor $ означает целую часть числа. Рекуррентное соотношение $$kP_(x)-(2k-1),xP_(x)+(k-1),P_(x) equiv 0, quad kge 2 ;$$ позволяет найти полином $ P_(x) $ если уже вычислены $ P_(x) $ и $ P_(x) $. ♦

В ортонормированном базисе пространства $ mathbb E_ $ матрица Грама из формулы скалярного произведения $$ langle X,Y rangle=(x_1,dots,x_n) G(X_1,dots,X_n) left( begin y_1 \ vdots \ y_n end right) $$ становится единичной и в таком базисе скалярное произведение становится стандартным : $$ langle X,Y rangle=sum_^n x_jy_j .$$

Следующая теорема устанавливает связь между двумя ортонормированными базисами в одном и том же пространстве.

Теорема. Матрица перехода от одного ортонормированного базиса к другому является ортогональной.

В пространстве $ mathbb R^_ $ матрица, составленная из столбцов произвольного ортонормированного базиса, является ортогональной.

Матричный формализм алгоритма Грама-Шмидта: QR-разложение

Рассмотрим пример из предыдущего пункта об ортогонализации системы векторов в $ mathbb R^5 $; только векторы будем рассматривать столбцами: $$ X_1=left[begin 1 \ 0 \ 0 \ 0 \ 1 end right], X_2=left[ begin 1 \ 1 \ 0 \ 1 \ 1 end right], X_3=left[ begin 1 \ 1 \ 1 \ 1 \ 1 end right] , . $$ Составим из них матрицу $$ A_ = left[ X_1,X_2,X_3 right] , . $$ Алгоритм Грама-Шмидта означает некоторые действия со столбцами этой матрицы, и эти действия могут быть записаны на языке матричного формализма, а именно — с помощью операции умножения этой матрицы на последовательность матриц определенного вида. В самом деле, на первом шаге алгоритма, «все остается на месте»: столбец $ _1 $ совпадает с $ X_ $, а оставшиеся столбцы мы пока не трогаем. Формально это «бездействие» можно записать с помощью умножения матрицы $ A_ $ на единичную матрицу порядка $ 3_ $. $$ Acdot E_ = left[_1,X_2,X_3 right] , . $$ Следующий шаг алгоритма уже менее тривиален: в получившейся матрице производятся действия над первыми двумя столбцами. При этом первый столбец остается неизменным, последний — тоже, а изменяется лишь второй: $$ _2 = X_2 + alpha_ _1 , . $$ Для получившейся на первом шаге матрицы, это действие эквивалентно домножению ее справа на матрицу $$ R_2 = left( begin 1 & alpha_ & 0 \ 0 & 1 & 0 \ 0 & 0 & 1 end right) , . $$ Если значение $ alpha_ $ вычисляется как указано в алгоритме: $$alpha_=- langle _1,X_2 rangle big/ langle _1,_1 rangle =- langle X_1,X_2 rangle big/ langle X_1,X_1 rangle , , $$ то получившаяся матрица $$ Acdot E_ R_2 = left[_1,_2,X_3 right] $$ имеет первые два столбца ортогональными. Следующее преобразование получившейся системы столбцов равносильно домножению получившейся матрицы справа на матрицу вида $$ R_3 = left( begin 1 & 0 & alpha_ \ 0 & 1 & alpha_ \ 0 & 0 & 1 end right) , . $$ Если значения $ alpha_ $ и $ alpha_ $ вычисляются как указано в алгоритме, то получившаяся матрица $$ Acdot E_ R_2 R_3 = left[_1,_2,_3 right] $$ имеет систему своих столбцов ортогональной. Можно произвести еще одно дополнительное домножение $$ Acdot E_ R_2 R_3 cdot left( begin 1/langle _1,_1 rangle & 0 & 0 \ 0 & 1/langle _2,_2 rangle & 0 \ & 0 & 1/ langle _3,_3 rangle end right) , , $$ превратив полученную матрицу в матрицу с ортонормированной системой столбцов.

Теперь обдумаем полученный результат. Матрицы, на которые производились домножения матрицы $ A_ $ имеют довольно специфическую форму: они — либо диагональные, либо же отличаются от единичной матрицы в одном их своих столбцов. Эти матрицы могут быть отнесены к типу матриц элементарных преобразований системы столбцов произвольной матрицы $ A_ $. Все они являются верхнетреугольными, и их произведение $ R_ $ относится к тому же типу. Обратная к верхнетреугольной также является верхнетреугольной. В результате, можно получить разложение матрицы $ A_ $ в произведение $$ A=Q_R^ , , $$ где вторая матрица в произведении является верхнетреугольной, а первая имеет свои столбцы ортонормированными.

Теорема [о QR-разложении]. Для любой вещественной матрицы $ A_^ $ ранга $ n 11) $ tilde R_ $, такие, что $$ A=Q tilde R , . $$

Пример. Для матрицы из предыдущего примера имеем:

$$ left( begin 1 & 1 & 1 \ 0 & 1 & 1 \ 0 & 0 & 1 \ 0 & 1 & 1 \ 1 & 1 & 1 end right) = $$ $$ =left( begin 1/sqrt & 0 & 0 \ 0 & 1/sqrt & 0 \ 0 & 0 & 1 \ 0 & 1/sqrt & 0 \ 1/sqrt & 0 & 0 end right) left< left( begin 1 & -1 & 0 \ 0 & 1 & 0 \ 0 & 0 & 1 end right) left( begin 1 & 0 & -1 \ 0 & 1 & -1 \ 0 & 0 & 1 end right) left( begin 1/sqrt & 0 & 0 \ 0 & 1/sqrt & 0 \ 0 & 0 & 1 end right) right>^ $$ $$ = left( begin 1/sqrt & 0 & 0 \ 0 & 1/sqrt & 0 \ 0 & 0 & 1 \ 0 & 1/sqrt & 0 \ 1/sqrt & 0 & 0 end right)left( begin sqrt & sqrt & sqrt \ 0 & sqrt & sqrt \ 0 & 0 & 1 end right) , . $$ ♦

Для квадратной неособенной вещественной матрицы $ A_ $ матрица $ Q_ $ в QR-разложении будет ортогональной.

Последний результат имеет уже самостоятельное значение, не относящееся к материалам настоящего раздела. Например, его можно использовать для обращения матрицы $ A_ $. Дело в том, что ортогональная матрица обращается достаточно просто: $ Q^ = Q^ $.

Видео:Угол между векторами. 9 класс.Скачать

Расстояние от точки до многообразия

Задача. Найти расстояние от заданного вектора $ X_ $ до заданного множества $ mathbb Ssubset mathbb E $.

Такая постановка требует немедленного уточнения: что такое расстояние от вектора до множества? Обратясь за помощью к геометрии, мы можем ввести это понятие, основываясь на понятии расстояния между точками: например, расстояние от точки $ Xin mathbb R^2 $ до множества $ mathbb S subset mathbb R^2 $ определить как минимальное из возможных расстояний между точками $ X_ $ и $ Y_ $, где $ Yin mathbb S $. Следующий пример показывает, что наше определение оказывается ущербным.

Пример. Множество

Доказать следующие свойства операции $ perp $:

а) $ left(mathbb E_1^<^> right)^<^>=mathbb E_1 $; б) $ left(mathbb E_1 +mathbb E_2 right)^<^>=mathbb E_1^<^> cap mathbb E_2^<^> $; в) $ left(mathbb E_1 cap mathbb E_2 right)^<^>=mathbb E_1^<^>+mathbb E_2^<^> $.

Доказать, что в пространстве квадратных матриц со скалярным произведением, заданным формулой

$$ langle A,B rangle = operatorname left(Acdot B^ right) = sum_^n a_b_ , $$ подпространство кососимметричных матриц является ортогональным дополнением подпространства симметричных матриц.

Вычисление расстояния

Теорема $ 2 $ из предыдущего пункта позволяет сформулировать результат, на котором и будет основано решение задачи вычисления расстояния.

Теорема 1. Для любого вектора $ Xin mathbb E $ существует единственное представление его в виде $$ X=X^<^>+X^<^> quad npu X^<^>in mathbb E_1, X^<^> in mathbb E_1^<^> . $$

В этом разложении вектор $ X^<^> $ называется ортогональной проекцией вектора $ X_ $ на $ mathbb E_1 $, а вектор $ X^<^> $ — ортогональной составляющей вектора $ X_ $ относительно $ mathbb E_1 $ или же перпендикуляром, опущенным из точки $ X_ $ на подпространство $ mathbb E_1 $.

Теорема 2. Длина перпендикуляра, опущенного из точки $ X_ $ на подпространство $ mathbb E_1 $ , равна расстоянию от этой точки до подпространства: $$left|X^<^>right|=min_ |X-Y| . $$

Доказательство. $$ X^<^>=left( X-X^<^> right) perp mathbb E_1 Rightarrow X^<^> perp left( -Y+X^<^> right) quad npu forall Y in mathbb E_1 . $$ По теореме Пифагора: $$ left|X^<^> right|^2+ left|X^<^> -Y right|^2 =left|X^<^>+ X^<^> -Y right|^2 = |X-Y|^2 Rightarrow $$ $$ Rightarrow left|X^<^> right|^2le |X-Y|^2 Rightarrow left|X^<^> right|le min_ |X-Y| . $$ С другой стороны, указанный минимум достигается при $ Y=X^<^> $ поскольку $ left|X^<^> right|=left|X-X^<^>right| $. ♦

Итак, задача, поставленная в начале ☞ ПУНКТА, решается вычислением $ left|X^<^> right| $. Для нахождения последнего числа сначала найдем базис $ $ подпространства $ mathbb E_1 $. Далее, ищем $ X^<^> $, принадлежащий $ mathbb E_1 $, в виде линейной комбинации базисных векторов: $$ X^<^>=alpha_1 X_1 + dots + alpha_k X_k . $$ Для нахождения скаляров $ alpha_1,dots , alpha_k $ используем тот факт, что вектор $ X^<^>=X-X^<^> $ должен быть ортогонален $ mathbb E_1 $, а значит, ортогонален каждому $ X_j $: $$langle X-X^<^>, X_j rangle =0 iff langle X^<^>, X_j rangle=langle X,X_j rangle . $$ Получаем систему линейных уравнений: $$ left< begin alpha_1 langle X_1,X_1 rangle &+ alpha_2 langle X_1,X_2 rangle &+ dots &+ alpha_k langle X_1,X_k rangle &= langle X,X_1 rangle, \ alpha_1 langle X_2,X_1 rangle & + alpha_2 langle X_2,X_2 rangle &+ dots &+ alpha_k langle X_2,X_k rangle &= langle X,X_2 rangle, \ dots & & & & dots \ alpha_1 langle X_k,X_1 rangle & + alpha_2 langle X_k,X_2 rangle &+ dots &+ alpha_k langle X_k,X_k rangle &= langle X,X_k rangle. end right. $$ с матрицей, которая нам уже известна как матрица Грама системы векторов: $ G(X_1,dots,X_k) $. Для однозначной разрешимости относительно $ alpha_1,dots , alpha_k $ необходимо и достаточно (см. ☞ теорема Кронекера-Капелли ), чтобы определитель этой матрицы — т.е. определитель Грама $ mathfrak G(X_1,dots,X_k) $ — был отличен от нуля.

Матрица Грама обращается в единичную если векторы $ X_1,dots,X_k $ входят в состав ортонормированного базиса пространства $ mathbb E_ $. Следовательно, по крайней мере в этом частном случае, система уравнений будет иметь единственное решение. В одном из последующих ☟ ПУНКТОВ будет установлен и более общий факт: $$ mathfrak(Y_1,dots,Y_k)=0 iff quad mbox quad quad mbox $$ Этот факт позволяет нам заключить, что, поскольку векторы $ $ — базисные для подпространства $ mathbb E_1 $, то система уравнений имеет единственное решение относительно $ alpha_1,dots , alpha_k $: $$alpha_1=alpha_1^,dots , alpha_k=alpha_k^ .$$ Теперь может быть найдена проекция вектора $ X_ $ на $ mathbb E_1 $: $$ X^<^>=alpha_1^ X_1 + dots + alpha_k^ X_k , $$ а затем и составляющая: $ X^<^>=X-X^<^> $.

Пример. Найти расстояние от точки $ X=[1,1,2,2,2] $ до подпространства

$$ mathbb E_1= left< Xin mathbb R^5 left| begin x_1&-x_2&-x_3&+x_4 & &= 0, \ 2,x_1&-x_2&-x_3&+2,x_4 &-x_5 &=0 end right. right> , $$ если скалярное произведение определяется стандартно: $ langle X,Y rangle=sum_^5 x_jy_j $.

Решение. Базис $ mathbb E_1 $ составляет фундаментальная система решений системы линейных уравнений, например: $$X_1=[0,-1,1,0,0], X_2=[-1,0,0,1,0], X_3=[1,1,0,0,1] .$$ Составляем матрицу Грама этой системы векторов и выписываем систему уравнений: $$ left( begin 2 & 0 & -1 \ 0 & 2 & -1 \ -1 & -1 & 3 end right) left( begin alpha_1 \ alpha_2 \ alpha_3 end right) = left( begin 1 \ 1 \ 4 end right) Rightarrow alpha_1=frac,, alpha_2=frac,, alpha_3=frac . $$ Ортогональная проекция вектора $ X_ $ на $ mathbb E_1 $: $$ X^<^>= frac X_1 + frac X_2 + frac X_3=left[frac,, frac,, frac,, frac,, frac right] , $$ а ортогональная составляющая вектора $ X_ $ относительно $ mathbb E_1 $: $$ X^<^>=X-X^<^>= left[frac,, frac,, frac,, frac,, — frac right] quad Rightarrow left|X^<^>right| =frac<sqrt> . $$

Ответ. $ 1/sqrt $.

Альтернативный способ вычисления расстояния от точки до линейного многообразия, заданного системой линейных уравнений ☞ ЗДЕСЬ.

Расстояние от точки $ X_ $ до линейного подпространства, базисными векторами которого являются $ X_1,dots,X_k $, вычисляется по формуле: $$ d=sqrt<frac<(X_1,dots,X_k, X)><(X_1,dots,X_k)>> . $$

Доказательство ☞ ЗДЕСЬ.

Пример. В пространстве полиномов с вещественными коэффициентами степеней не выше $ 5_ $ со скалярным произведением, заданным формулой

$$langle p(x),q(x) rangle = int_^1 p(t)q(t) d,t $$ найти расстояние от полинома $ p(x)= -x^5+x^3-3,x+1 $ до линейного подпространства четных полиномов.

Решение. Базис подпространства четных полиномов состоит, например, из $ 1,x^2,x^4 $. Имеем: $$ (1,x^2,x^4)=left| begin int_^1 1 cdot 1 d,t & int_^1 1 cdot t^2 d,t & int_^1 1 cdot t^4 d,t \ int_^1 1 cdot t^2 d,t & int_^1 t^2 cdot t^2 d,t & int_^1 t^2cdot t^4 d,t \ int_^1 1 cdot t^4 d,t & int_^1 t^2 cdot t^4 d,t & int_^1 t^4 cdot t^4 d,t end right|=left| begin 2 & 2/3 & 2/5 \ 2/3 & 2/5 & 2/7 \ 2/5 & 2/7 & 2/9 end right|=frac ; $$ $$ (1,x^2,x^4,p(x))=left| begin 2 & 2/3 & 2/5 & 2 \ 2/3 & 2/5 & 2/7 & 2/3 \ 2/5 & 2/7 & 2/9 & 2/5 \ 2 & 2/3 & 2/5 & 3632/495 end right|=frac . $$ Отношение полученных определителей даст квадрат расстояния: $$ d^2=2642/495 . $$ К этому же ответу можно было прийти и быстрее если заметить, что при заданном скалярном произведении любой четный полином ортогонален любому нечетному полиному. Следовательно для выделения у $ p(x) $ ортогональной составляющей относительно подпространства четных полиномов достаточно оставить в его каноническом виде только нечетные одночлены. Расстояние равно норме полинома $ p(x)-1 $. ♦

Подводя итог: определители Грама полностью решают задачу о вычислении расстояния от точки до линейного подпространства в любом евклидовом пространстве; этот результат легко обобщается на произвольное линейное многообразие.

Теорема 3. Расстояние от точки $ X_ $ до линейного многообразия $ mathbb M=X_0+mathbb E_1 $ равно длине ортогональной составляющей вектора $ X-X_0 $ относительно подпространства $ mathbb E_1 $.

Доказательство. Геометрический смысл понятен из рисунков, иллюстрирующих решение проблемы в $ mathbb R^ $: надо свести задачу к случаю из предыдущей теоремы с помощью сдвига всей конструкции на вектор $ (-X_0) $.

Формальности: $$ min_ |X-Y| =min_ |X-(X_0+Z)|= min_ |(X-X_0)-Z)| . $$ Последняя величина — это расстояние от точки $ X-X_0 $ до $ mathbb E_1 $ ; согласно теореме $ 2 $ оно равно длине ортогональной составляющей вектора $ X-X_0 $ относительно $ mathbb E_1 $. ♦

Расстояние от точки $ X_ $ до линейного многообразия, заданного параметрически

Вычисление расстояния между линейными многообразиями (и некоторыми другими объектами, заданными алгебраическими уравнениями) ☞ ЗДЕСЬ.

Угол между вектором и линейным многообразием

Углом между вектором $ Xin mathbb E $ и линейным подпространством $ mathbb E_1 subset mathbb E $ назовем число — точную нижнюю грань множества углов между $ X_ $ и всевозможными векторами $ Y in mathbb E_1 $. Углом между вектором $ Xin mathbb E $ и линейным многообразием $ mathbb M=X_0+mathbb E_1 $ называется угол между $ X_ $ и $ mathbb E_1 $.

Теорема. Угол между вектором $ Xin mathbb E $ и линейным подпространством $ mathbb E_1 subset mathbb E $ равен углу между этим вектором и его ортогональной проекцией $ X^<^> $ на $ mathbb E_1 $.

Эта теорема сводит задачу к решенной в предыдущих пунктах задаче вычисления расстояния от вектора до подпространства, только теперь интерес смещается от ортогональной составляющей вектора к его ортогональной проекции.

Пример. Определить угол между вектором $ X_0=[1,0,3,0] $ и линейной оболочкой

Решение. Воспользуемся результатом, приведенным ☞ ЗДЕСЬ (для правильной стыковки рассматриваем все векторы как столбцы): $$ X_=L(L^ L_)^ L^ X_0 , . $$ Здесь $$ L=left(begin 5 & 1 & 2 \ 3 & 1 & -1 \ 4 & 4 & 1 \ -3 & 5 & 2 end right), qquad L^ L = left(begin 59 & 9 & 5 \ 9 & 43 & 15 \ 5 & 15 & 10 end right), $$ $$ (L^ L )^ = left(begin 41/2312 & -3/2312 & -2/289\ -3/2312 & 113/2312 & -21/289\ -2/289 & -21/289 & 307/1445 end right) $$ $$ L(L^ L_)^ L^= left(begin 9/10 & -1/5 & 1/5 & -1/10 \ -1/5 & 3/5 & 2/5 & -1/5 \ 1/5 & 2/5 & 3/5 & 1/5\ -1/10 & -1/5 & 1/5 & 9/10 end right), quad X_= left(begin 3/2 \ 1 \ 2 \ 1/2 end right) , . $$ $$ widehat<X_0,X_>=arccos frac <langle X_0,X_rangle ><sqrt< langle X_0,X_0rangle langle X_,X_ rangle>>= arccos frac<sqrt>= frac , . $$ ♦

Видео:Определение кратчайшей расстояние от точки до плоскости способом замены плоскостей проекцииСкачать

Свойства матрицы Грама

Теорема. $ (X_,dots,X_m)=0 $ тогда и только тогда, когда система векторов $ <X_,dots,X_m > $ линейно зависима.

Доказательство. Если система векторов $ <X_,dots,X_m> $ линейно зависима, то имеет место равенство $$alpha_1 X_1+alpha_2 X_2+dots+alpha_ X_=mathbb O$$ при некотором нетривиальном наборе скаляров $ alpha_1=alpha_1^,dots,alpha_m=alpha_m^ $. Домножим это соотношение (скалярно) на векторы $ X_1,X_2,dots,X_m $, получим систему уравнений, которую перепишем в матричном виде: $$ left( begin langle X_1,X_1 rangle & langle X_1,X_2 rangle & dots & langle X_1,X_m rangle \ langle X_2,X_1 rangle & langle X_2,X_2 rangle & dots & langle X_2,X_m rangle \ dots & & & dots \ langle X_m,X_1 rangle & langle X_m,X_2 rangle & dots & langle X_m,X_m rangle end right) left( begin alpha_1 \ alpha_2 \ vdots \ alpha_m end right)= left( begin 0 \ 0 \ vdots \ 0 end right) . $$ Если рассмотреть эту систему относительно переменных $ alpha_,dots,alpha_m $, то она оказывается однородной и, по предположенному, будет иметь нетривиальное решение $ alpha_1=alpha_1^,dots,alpha_m=alpha_m^ $ . Следовательно (см. ☞ ТЕОРЕМА КРОНЕКЕРА-КАПЕЛЛИ ) ее определитель равен нулю: $ (X_,dots,X_m)=0 $.

Обратно, если определитель Грама равен нулю, то предыдущая система имеет нетривиальное решение относительно $ alpha_,dots,alpha_m $. Пусть $ alpha_1=alpha_1^,dots,alpha_m=alpha_m^ $ — какое-то из этих решений. Составим вектор $$X^= alpha_1^ X_1+alpha_2^ X_2+dots+alpha_^ X_ $$ и вычислим скалярное произведение его на самого себя: $$ langle X^,X^ rangle = $$ $$ = (alpha_1^ ,alpha_2^ ,dots,alpha_m^ ) underbrace<left( begin langle X_1,X_1 rangle & langle X_1,X_2 rangle & dots & langle X_1,X_m rangle \ langle X_2,X_1 rangle & langle X_2,X_2 rangle & dots & langle X_2,X_m rangle \ dots & & & dots \ langle X_m,X_1 rangle & langle X_m,X_2 rangle & dots & langle X_m,X_m rangle end right) left(begin alpha_1^ \ alpha_2^ \ vdots \ alpha_m^ endright)>_<=mathbb O_>=0 . $$ Таким образом длина вектора $ X^ $ равна нулю, и, следовательно, по аксиоме 4 , сам вектор $ X^ $ — нулевой. Но тогда система векторов $ <X_,dots,X_m> $ линейно зависима. ♦

Ранг матрицы Грама совпадает с рангом системы порождающих ее векторов:

Если какой-то главный минор матрицы Грама обращается в нуль, то и все главные миноры бóльших порядков обращаются в нуль.

Теорема. $ (X_,dots,X_m) ge 0 $ для любого набора векторов $ <X_,dots,X_m > $.

Доказательство ☞ ЗДЕСЬ

Матрица Грама линейно независимой системы векторов является положительно определенной. Матрица Грама произвольной системы векторов является положительно полуопределенной.

Дальнейшие свойства матрицы и определителя Грама ☞ ЗДЕСЬ

Видео:18+ Математика без Ху!ни. Скалярное произведение векторов. Угол между векторами.Скачать

Задачи

Видео:ВЕКТОРЫ. МЕТОД КООРДИНАТ 1. Координаты точки. Расстояние между двумя точкамиСкачать

Источник

Материалы этого раздела составлены на основе книги

Шилов Г.Е. Математический анализ. Конечномерные линейные пространства. М.Наука.1969

Видео:Координаты вектора. 9 класс.Скачать

Расчет евклидова расстояния с помощью NumPy

В этом руководстве мы рассмотрим, как рассчитать евклидово расстояние между двумя точками в Python с помощью Numpy.

Что такое евклидово расстояние?

Евклидово расстояние — это фундаментальная метрика расстояния, относящаяся к системам в евклидовом пространстве.

Евклидово пространство — это классическое геометрическое пространство, с которым вы знакомитесь на уроке математики, обычно связанное с 3 измерениями. Хотя его также можно приписать к любой неотрицательной целочисленной размерности.

Евклидово расстояние — кратчайшая прямая между двумя точками в евклидовом пространстве.

Название происходит от Евклида, который широко известен как «отец геометрии», так как это было единственное пространство, которое люди в то время обычно задумывали. Со временем в физике и математике наблюдались различные типы пространства, такие как пространство Аффин.

В 3-мерном евклидовом пространстве кратчайшая прямая между двумя точками всегда будет прямой линией между ними.

Учитывая этот факт, евклидово расстояние не всегда является наиболее полезной метрикой для отслеживания при работе со многими размерностями, мы сосредоточимся на 2D и 3D евклидовом пространстве для расчета евклидова расстояния.

Вообще говоря, евклидова расстояние широко используется в разработке 3D-миров, а также алгоритмов машинного обучения, которые включают в себя метрики расстояния, такие как K-ближайшие соседи. Как правило, евклидово расстояние будет представлять, насколько похожи две точки данных, предполагая, что некоторая кластеризация на основе других данных уже была выполнена.

Математическая формула

Математическая формула расчета евклидова расстояния между 2 точками в 2D пространстве:

Формула легко адаптируется к 3D-пространство, а также к любому размеру:

Общая формула может быть упрощена до:

Острый глаз может заметить сходство между евклидовым расстоянием и теоремой Пифагора:

На самом деле существует связь между ними — евклидовое расстояние рассчитывается с помощью теоремы Пифагора, учитывая декартовы координаты двух точек.

Из-за этого евклидова расстояние иногда называют расстоянием Пифагора, хотя прежнее название гораздо более известно.

Примечание: Две точки являются векторами, но выход должен быть скалярным.

Мы будем использовать NumPy для расчета этого расстояния для двух точек, и один и тот же подход используется для 2D и 3D пространств:

Расчет евклидова расстояния в Python с помощью NumPy

Во-первых, нам нужно будет установить библиотеку NumPy:

Теперь давайте импортируем его и настроим две наши точки с декартовыми координатами (0, 0, 0) и (3, 3, 3):

Вместо того, чтобы выполнять расчет вручную, мы будем использовать вспомогательные методы NumPy, чтобы сделать его еще проще!

Операции и математические функции, необходимые для расчета евклидова расстояния, довольно просты: сложение, вычитание, а также функция квадратного корня. Несколько слагаемых также можно заменить суммой:

NumPy предоставляет нам функцию np.sqrt(), представляющую функцию квадратного корня, а также функцию np.sum(), которая представляет собой сумму. При этом расчет евклидова расстояния в Python прост и интуитивно понятен:

Данная формула дает нам довольно простой результат:

Что равно 27. Осталось все, что получить квадратный корень из этого числа:

В истинном питоновом духе это можно сократить до одной строки:

И вы даже можете вместо этого использовать встроенные методы pow() и sum() математического модуля Python, хотя они требуют, чтобы вы немного поработали с вводом, который удобно абстрагируется с помощью NumPy, так как функция pow() работает только со скалярами (каждый элемент в массиве индивидуально) и принимает аргумент — в какой степени вы увеличиваете число.

Этот подход, однако, интуитивно больше похож на формулу, которую мы использовали раньше:

Это также приводит к:

np.linalg.norm()

Функция np.linalg.norm() представляет математическую норму. По сути, нормой вектора является его длина. Эта длина не обязательно должна быть евклидовым расстоянием, а может быть и другими расстояниями. Евклидово расстояние-это норма L2 вектора (иногда известная как евклидова норма), и по умолчанию функция norm() использует L2 — параметр ord имеет значение 2.

Если бы вы установили для параметра ord какое-то другое значение p, вы бы рассчитали другие p-нормы. Например, норма L1 вектора-это расстояние Манхэттена!

Имея это в виду, мы можем использовать функцию np.linalg.norm() для легкого и гораздо более чистого вычисления евклидова расстояния, чем использование других функций:

Это приводит к печати расстояния L2/евклида:

Нормализация L2 и нормализация L1 широко используются в машинном обучении для нормализации входных данных.

Мы также можем использовать точечное произведение для расчета евклидова расстояния. В математике точечное произведение является результатом умножения двух векторов равной длины, а результатом является единственное число — скалярное значение. Из-за возвращаемого типа его иногда также называют «скалярным продуктом». Эту операцию часто называют внутренним произведением для двух векторов.

Для расчета точечного произведения между 2 векторами вы можете использовать следующую формулу:

С помощью NumPy мы можем использовать функцию np.dot(), передавая два вектора.

Если мы вычислим точечное произведение разницы между обеими точками с той же разницей — мы получим число, которое находится в зависимости от евклидова расстояния между этими двумя векторами. Извлечение квадратного корня из этого числа дает нам расстояние, которое мы ищем:

Конечно, вы также можете сократить это до однострочного:

Использование встроенной системы math.dist()

В Python есть встроенный метод в математическом модуле, который вычисляет расстояние между 2 точками в трехмерном пространстве. Однако это работает только с Python 3.8 или более поздней версии.

math.dist()принимает два параметра, которые являются двумя точками, и возвращает евклидово расстояние между этими точками.

Примечание: Обратите внимание, что две точки должны иметь одинаковые размеры (т.е. оба в 2d или 3d пространстве).

Теперь, чтобы вычислить Евклидово расстояние между этими двумя точками, мы просто заправляем их в метод thedistdist():

Заключение

Данная метрика используется во многих контекстах в интеллектуальном анализе данных, машинном обучении и ряде других областей и является одной из фундаментальных метрик расстояния.

Видео:Самый короткий тест на интеллект Задача Массачусетского профессораСкачать

Вычислить расстояние между двумя векторами разной длины

Существуют разные методы расчета расстояния между двумя векторами одной длины: евклидовой, манхэттенской, хэмминской.

Мне интересно, какой метод будет вычислять расстояние между векторами разной длины.

Видео:Определение кратчайшей расстоянии от точки до плоскостиСкачать

ОТВЕТЫ

Ответ 1

Формула евклидова расстояния находит расстояние между любыми двумя точками в евклидовом пространстве.

Точка в евклидовом пространстве также называется евклидовым вектором.

Вы можете использовать формулу Евклидова расстояния для вычисления расстояния между векторами двух разных длин.

Для векторов различной размерности применяется тот же принцип.

Предположим, что вектор более низкой размерности также существует в пространстве высших мер. Затем вы можете установить все недостающие компоненты в векторе нижнего измерения равным 0, чтобы оба вектора имели одинаковую размерность. Затем вы использовали бы любую из упомянутых формул расстояния для вычисления расстояния.

Например, рассмотрим двумерный вектор A в R² с компонентами (a1,a2) и трехмерный вектор B в R³ с компонентами (b1,b2,b3) .

Чтобы выразить A в R³ , вы должны установить его компоненты в (a1,a2,0) . Тогда евклидово расстояние d между A и B можно найти по формуле:

В вашем конкретном случае компоненты будут либо 0 , либо 1 , поэтому все различия будут -1 , 0 или 1 . Квадратные различия будут тогда 0 или 1 .

Если вы используете целые числа или отдельные биты для представления компонентов, вы можете использовать простые побитовые операции вместо некоторой арифметики ( ^ означает XOR или exclusive or ):

И мы полагаем, что конечными компонентами A являются 0 , поэтому окончательная формула будет:

Ответ 2

Вы можете попытаться рассчитать среднее минимальное расстояние между двумя векторами p и q размеров n и m (n

Ответ 3

Вы не можете напрямую вычислять расстояния между векторами различной длины.

Все предложения здесь начинаются с функции, которая отображает вектор нижней длины в более длинную, а затем выполняет вычисления как обычно.

Существует множество функций (на самом деле, бесконечно много), которые можно использовать:

- Заполните нули. Это проще всего сделать. Скажем, если у вас есть машина и нужно вычислить ее расстояние до самолета, это помещает автомобиль на уровень моря.

- Посмотрите на недостающие значения где-нибудь. В примере с автомобильным самолетом вы запустили свою базу геоданных и просмотрели высоту с долготы/широты.

- Используйте некоторую математическую функцию.

Поскольку результат вычисления расстояния сильно зависит от функции, которая преобразует более короткий вектор в более длинный, каждый должен четко понимать, какая функция используется. Либо потому, что все в полях согласны с тем, что имеет смысл только одна функция, или потому, что функция, используемая при преобразовании, отмечена.

📺 Видео

Угол между векторами | МатематикаСкачать

Способ вращения. Определение истинной величины отрезка.Скачать

Расстояние между скрещивающимися прямымиСкачать

Расстояние между параллельными прямымиСкачать

Определение расстояние между параллельными прямыми (Способ замены плоскостей проекции).Скачать

9 класс, 6 урок, Уравнение окружностиСкачать

Расстояние между двумя точками. Координаты середины отрезка.Скачать

Длина отрезкаСкачать

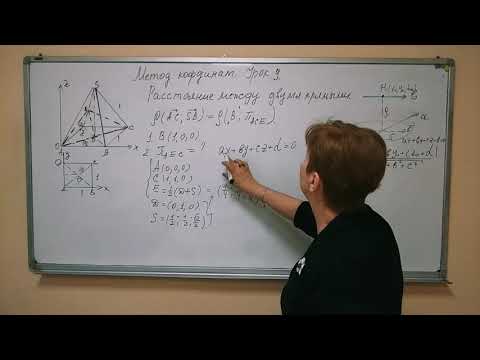

Метод координат. Урок № 9. Нахождение расстояния между двумя скрещивающимися прямыми.Скачать